Hallo allerseits,

am nächsten Donnerstag treffen wir uns zum Technik-Treff. Wer mag, kann Geräte und Fragen mitbringen, und wir werden uns nach bestem Wissen und Gewissen damit befassen. Es könnte wieder zu spontanen Kurzvorträgen kommen. Bitte auch die beiden Termine weiter unten im Text beachten! 😇

Donnerstag, 12. Februar 19:00 Uhr

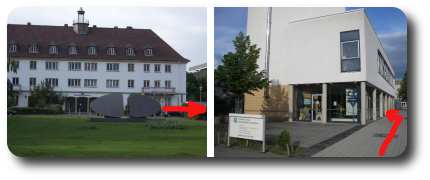

Ostfalia Campus Wolfsburg, Gebäude C, Seminarraum 127, Robert-Koch-Platz 8A, 38440 Wolfsburg Stadtplan anzeigen , Navigation und Fahrplanauskunft

Di.Day hier bei uns in der Nähe

Seit Jahresbeginn findet jeden ersten Sonntag ein digitaler Unabhängigkeitstag statt. Es geht im Wesentlichen darum, sich von der Handvoll Big-Tech Unternehmen außerhalb Europas unabhängig zu machen. In kleinen Schritten soll man probieren, die digitalen Fesseln zu lösen. Manche folgen jeden Monat einem Wechselrezept. Dabei gilt dann oft die Plus-1-Regel. Man installiert zum Beispiel neben dem bekannten Messengern aus dem Hause META einfach den freien, unabhängigen Signal-Messenger auf dem Smartphone. Dann hat man METAs Datenkrake zwar noch eine Weile installiert, kann aber zum Beispiel im Status seine Kontakte darauf hinweisen, dass man nicht mehr als gratis Datenspender für ein Milliardengeschäft zur Verfügung steht.

Für alle, die sich das nicht allein zutrauen, gibt es regionale Termine. Dort bieten IT-Profis Unterstützung an.

Sonntag 1. März von 14-16:00 Uhr in Gifhorn

Sonntag 1. März von 15-17:30 in Dannenbüttel

CLT2025 – Vortrags-Programm online

Die Chemnitzer Linux-Tage 2026 laden am 28. und 29 März erneut an die Technische Universität Chemnitz ein und zählen zu den bedeutendsten Veranstaltungen rund um Linux und Open Source im deutschsprachigen Raum. Besucherinnen und Besucher erwartet ein breit gefächertes Programm mit zahlreichen Vorträgen und praxisnahen Workshops, das sich sowohl an Einsteigerinnen und Einsteiger als auch an erfahrene IT-Fachleute richtet. Mit dem CLT-Junior-Programm gibt es was für Teenager und die Kleinsten werden im Kinderparadies bespaßt.

In den Vorträgen geben Expertinnen und Experten Einblicke in aktuelle Entwicklungen freier Software, IT-Sicherheit, Datenschutz, digitale Souveränität sowie den Einsatz offener Technologien in Bildung, Verwaltung und Wirtschaft. Ergänzt wird das Programm durch Hands-on-Workshops, in denen Teilnehmende ihr Wissen vertiefen, neue Werkzeuge ausprobieren und direkt mit den Referierenden ins Gespräch kommen können. Eine begleitende Ausstellung, Community-Stände und Mitmachangebote runden die Veranstaltung ab und machen die Chemnitzer Linux-Tage zu einem Treffpunkt für Austausch, Lernen und Vernetzung.

Lesestoff

In der aktuellen LinuxUser Community-Edition geht es im Editorial um den Deutschland-Stack, welcher als „nationale souveräne Technologie-Plattform für die Digitalvorhaben in Deutschland“ quasi Einheit bringen soll.

Weitere Themen:

Leseratte : Gute OCR-Programme sind unter Linux Mangelware. Tesseract erhalten Sie eine universelle, mehrsprachige Software zum automatisierten Erkennen von Texten.

Suchgenie: Anytxt Searcher ist kürzlich aus der Windows-Welt in das Linux-Universum eingetaucht. Das Tool fördert blitzschnell Ergebnisse zutage und bereitet sie visuell ansprechend auf.

Klingt gut!: EasyEffects hilft dem Sound von notorisch scheppernden

Notebook-Lautsprechern, Kopfhörern und Mikrofonen auf die Sprünge.

Bis dann,

Norbert